Unos días atrás, el Director Financiero de una de las consultoras más reconocidas del mundo recibió un mensaje de WhatsApp que parecía proceder de la Presidente y Directora Ejecutiva (CEO) de la empresa, diciendo que necesitaba ayuda con una transacción financiera vinculada a una adquisición. La supuesta CEO señaló que un asesor externo de un estudio jurídico que suele trabajar con la firma organizaría una reunión para discutir más detalles.

Poco después, el responsable de las operaciones financieras de la empresa recibió una invitación para unirse de manera urgente a una videoconferencia a través de Zoom. En una comunicación escueta, la Presidente de la consultora manifestó que debían actuar con rapidez extrema, agregando que el asesor legal del bufete de abogados proporcionaría toda la información necesaria. Una vez finalizada la llamada, el aparente representante del estudio envió un correo electrónico con instrucciones precisas sobre la solicitud, junto con los datos de una cuenta bancaria a la que debían transferirse $2.9 millones de dólares.

Sin embargo, el director financiero no realizó ninguna transacción. Había algunos elementos que no le terminaban de convencer y le hacían sospechar que algo no estaba bien. Aunque los mensajes de texto y audio de WhatsApp parecían ser de la CEO, era fuera de lo común que se comunicara de esta manera, en lugar de hacerlo a través de los canales habituales de la empresa, como el correo electrónico o a través de Teams, una plataforma de comunicación y colaboración empresarial desarrollada por Microsoft y ampliamente utilizada en entornos corporativos y educativos.

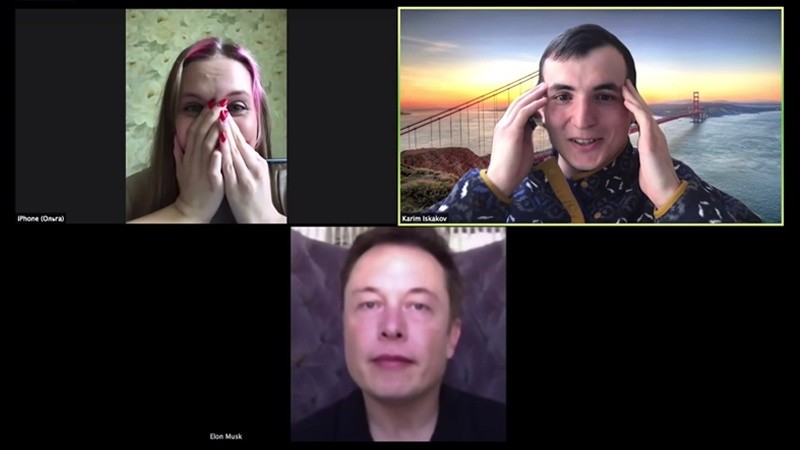

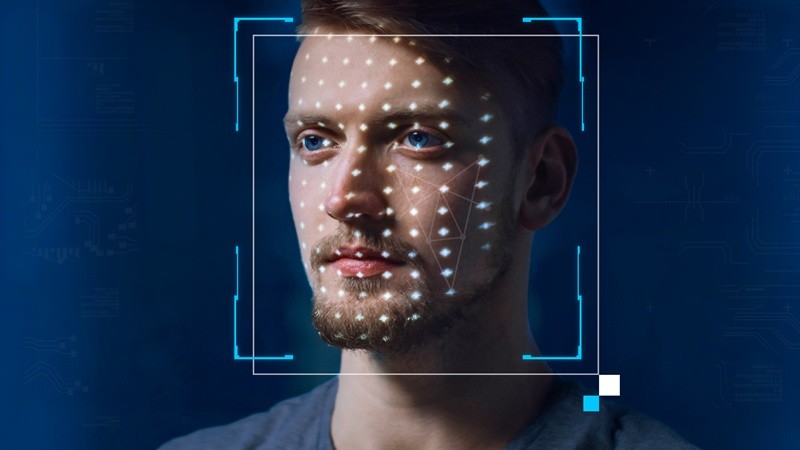

Por otra parte, acelerar una transacción como esta resultaba inusual, ya que en otras ocasiones, las operaciones comerciales siempre fueron cuidadosamente revisadas y documentadas. Además, el número de teléfono en WhatsApp no coincidía con el de la Directora Ejecutiva, lo que aumentó su desconfianza del ejecutivo financiero frente a la situación. Y para sumar aún más elementos anormales, la apariencia y comportamiento de la supuesta CEO durante la reunión de Zoom resultaban francamente extraños, solo habló una vez con un tono monocorde y sus movimientos corporales eran mínimos. Todos estos aspectos hicieron reflexionar detenidamente al ejecutivo, preguntándose si la imagen de la máxima autoridad de la empresa podría haberse tratado de un video deepfake creado con intenciones deshonestas. Y así fue.

Afortunadamente, la sólida formación y experiencia del Director Financiero le indicaban que, incluso para proyectos altamente confidenciales y urgentes, existían protocolos establecidos que debían seguirse al pie de la letra. El ejecutivo procedió a verificar la inusual situación con su superior jerárquico, quien instruyó que el siguiente paso era contactar al Centro de Operaciones de Seguridad de la compañía. Los equipos especializados fueron alertados de inmediato y, tras una ágil investigación, lograron desenmascarar a los sofisticados estafadores antes de que lograran su objetivo. La firme adherencia a los procedimientos y la oportuna intervención de los profesionales evitaron que la consultora cayera víctima de un ciberataque de ingeniería social de alto riesgo.

Los deepfakes, videos falsos hiperrealistas que manipulan la imagen o voz de una persona para hacerla decir o hacer algo que no hizo, se han convertido en una amenaza creciente para el mundo empresarial y financiero a escala global. Esta tecnología permite crear contenido audiovisual falso extremadamente convincente y verosímil, por lo que rápidamente se ha erigido como una herramienta cada vez más utilizada para realizar estafas y fraudes millonarios de ingeniería social.

Este caso se suma a otro incidente similar sucedido el pasado mes de febrero, cuando el empleado de una multinacional con sede en Hong Kong fue engañado para participar en una videoconferencia falsa con los que creía que eran varios miembros del personal de la empresa. En este caso, los estafadores utilizaron esta tecnología para generar deepfakes del Director Financiero (CFO) y otros trabajadores de la compañía, logrando así manipular la conversación para que el empleado autorizara una transferencia por más de 25 millones de dólares. El trabajador nunca sospechó nada, ya que la apariencia y el comportamiento de los participantes de la reunión eran virtualmente idénticos a sus colegas.

Estos elaborados fraudes, meticulosamente estudiados al detalle por los ciberdelincuentes tras un profundo análisis y tareas de inteligencia previas, apuntan a blancos corporativos de alto valor con el fin de maximizar sus ganancias ilícitas. Estos criminales eligen cuidadosamente sus víctimas entre las principales empresas y ejecutivos, pues un golpe exitoso contra estos objetivos lucrativos puede representar botines de millones de dólares. Sin embargo, llevar a cabo estos sofisticados ataques de ingeniería social requiere una planificación y preparación exhaustivas, que van desde el robo de información sensible hasta el estudio minucioso de los protocolos, personalidades y dinámicas internas de las organizaciones seleccionadas como blanco.

Pero no todos los ciberdelincuentes están dispuestos a invertir tiempo y esfuerzo en analizar a fondo a sus víctimas potenciales. Otros, más expeditivos y oportunistas, optan por blancos más accesibles: ciudadanos comunes. Recurriendo a deepfakes para personificar con inquietante precisión a celebridades o figuras públicas de renombre, intentan estafar y sacar dinero a incautos a través de falsos eventos online, programas de inversión fraudulentos u otros engaños que se aprovechan de la ingenuidad y codicia humana. Si bien estos ataques suelen implicar montos menores que los mega fraudes corporativos, su impacto colectivo es igualmente dañino, al socavar la confianza pública y permitir a los delincuentes financiar operaciones aún más ambiciosas con los fondos obtenidos.

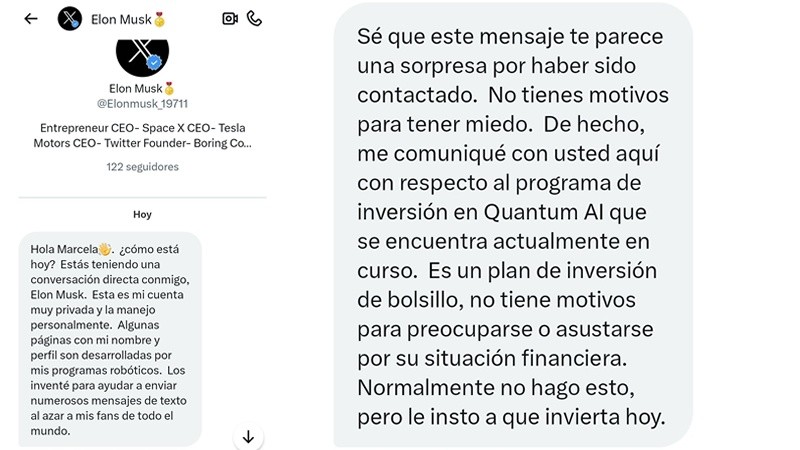

Un caso que adquirió relevancia internacional sucedió el pasado mes de abril, cuando una mujer surcoreana perdió 70 millones de wones (poco más de 50.000 dólares) al ser engañada por un deepfake que aparentaba ser Elon Musk. La víctima, Jeong Ji-sun, fue persuadida para invertir después de que el estafador, haciéndose pasar por Musk, la agregó en Instagram, donde compartió detalles personales y profesionales para ganarse su confianza. Le habló sobre sus hijos, le mostró una foto de él en el trabajo, le contó que solía ir a Tesla o SpaceX en helicóptero y que acostumbra a contactar aleatoriamente a fans en las redes sociales para entablar amistad. Incluso, durante una videollamada, el falso Musk llegó a decirle que la amaba.

Posteriormente, el ciberdelincuente proporcionó a su crédula víctima los datos de una cuenta bancaria, alentándola a realizar supuestas inversiones porque se sentía “feliz de ver a sus fans hacerse ricos”. Seducida por la promesa de amor y fortuna, Jeong Ji-sun terminó transfiriendo una cuantiosa suma de dinero al impostor, antes de que este desapareciera para siempre con el lucrativo botín.

Los deepfakes se están convirtiendo en una amenaza cada vez más común, muchas veces suplantando la identidad de personas que conocemos y apreciamos, como familiares, amigos y compañeros de trabajo. Las consecuencias de caer víctima de estos engaños pueden ser graves, ocasionando enormes pérdidas económicas, reputacionales o incluso legales. Es fundamental mantenerse alerta, prestando atención a los pequeños detalles que los delatan, como expresiones faciales poco naturales, movimientos de labios desincronizados con el audio, y sobre todo, apelando al pensamiento crítico. La desconfianza saludable y el escepticismo inteligente son herramientas invaluables y gratuitas para un mundo en el que la realidad se torna cada vez más indistinguible de la ficción sintética de la inteligencia artificial.